导航

python教程

最近点对问题

自动化测试

defer

postgresql

密码学

Flink Sql

音视频

小目标

ICU

信号维度

ACL

Executor

java项目实战

hevc

学习方法

嵌入式linux

前端酒店管理系统

Revit二次开发

ollama

2025/2/6 23:07:38从零到一:如何用Ollama和OpenUI构建强大的AI模型库

搭建开源大模型平台的步骤与模型介绍 在这篇文章中,我将分享如何在Windows上使用Ollama和OpenUI搭建开源大模型平台的步骤,并介绍我所部署的几个模型及其擅长的领域。 目录 搭建开源大模型平台的步骤与模型介绍一、搭建平台步骤1. 安装Ollama2. 安装Ope…

240922-chromadb的基本使用

A. 背景介绍

ChromaDB 是一个较新的开源向量数据库,专为高效的嵌入存储和检索而设计。与其他向量数据库相比,ChromaDB 更加专注于轻量化、简单性和与机器学习模型的无缝集成。它的核心目标是帮助开发者轻松管理和使用高维嵌入向量,特别是与生…

LLM | 迁移 ollama 模型文件到新机器(支持离线运行)

1. 详细步骤

以qwen2.5:0.5b-instruct-fp16为例

1.1 迁移 manifests 文件

# 本地机器

# 查看 manifests 下的配置文件

more ~/.ollama/models/manifests/registry.ollama.ai/library/qwen2.5/0.5b-instruct-fp16

# 输出类似如下

{"schemaVersion": 2,"mediaT…

本地安装Ollama+WebUI

本地安装OllamaWebUI

B站教程地址:https://www.bilibili.com/video/BV1Kz421h7Jk/?spm_id_from333.337.search-card.all.click&vd_source42b07826977d09765ec11b9fa06715e5

一、下载Ollama

https://ollama.com/download 支持mac、linux、windows

选择在ubu…

大模型笔记02--基于fastgpt和oneapi构建大模型应用平台

大模型笔记02--基于fastgpt和oneapi构建大模型应用平台 介绍部署&测试部署fastgptoneapi服务部署向量模型m3e和nomic-embed-text测试大模型 注意事项说明 介绍

随着大模型的快速发展,众多IT科技厂商都开发训练了各自的大模型,并提供了各具特色的AI产…

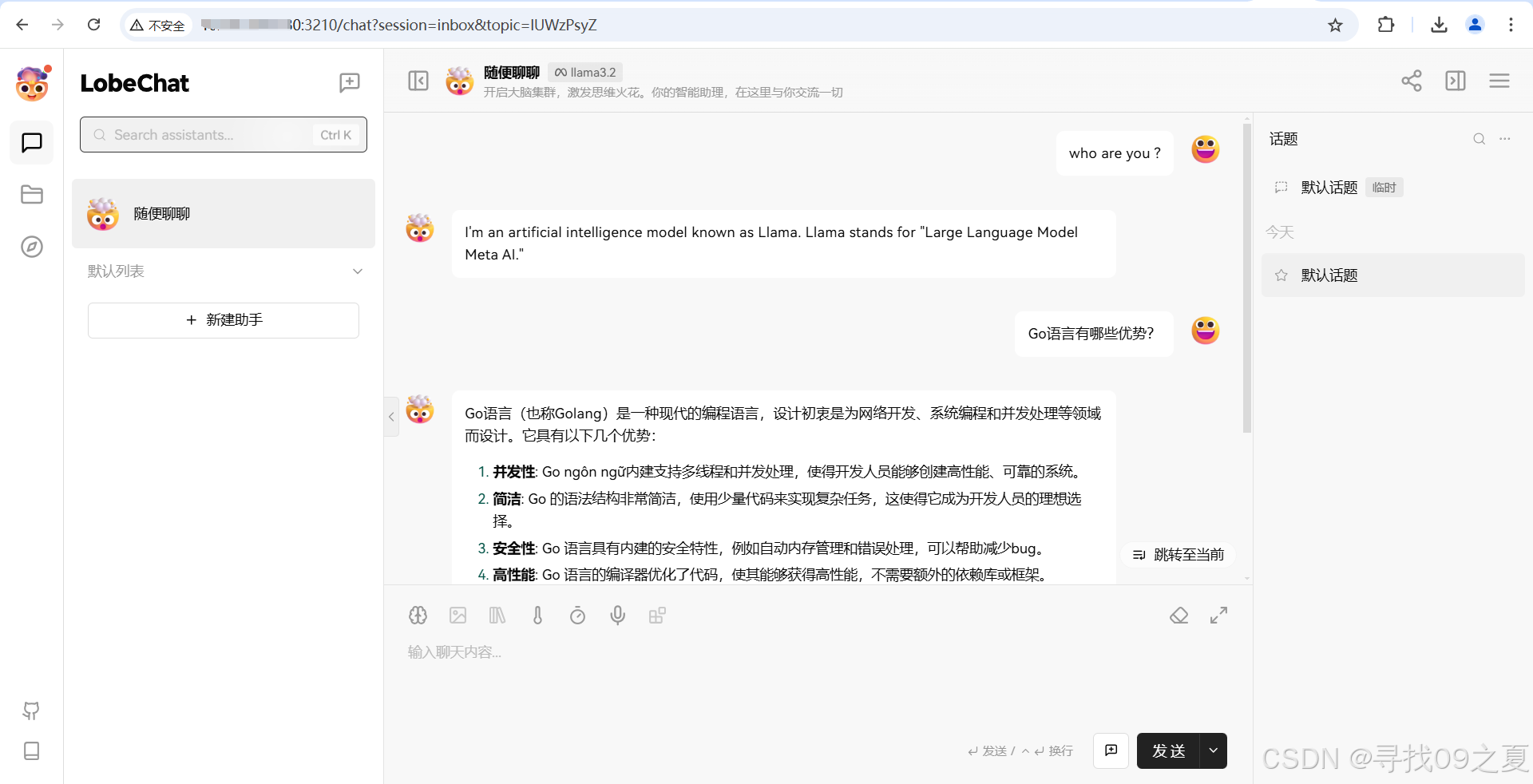

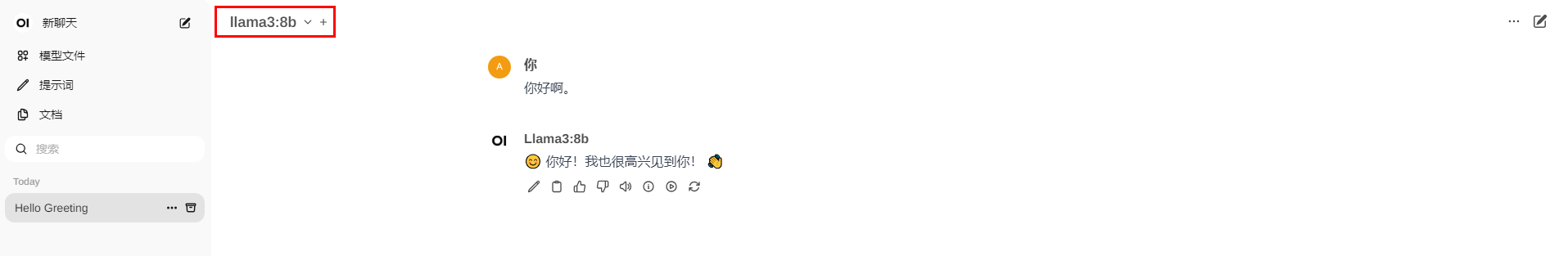

使用LobeChat+Ollama快速搭建本地大模型,离线可用

文章目录 准备工作下载Ollama什么是Ollama 参考文献 分享一下如何部署本地大模型,让它成为你的离线助手。 准备工作

服务器或者电脑一台,配置越高越好, Windows和Mac皆可,Widows最好内存8G以上而且带一块好一点的显卡;…

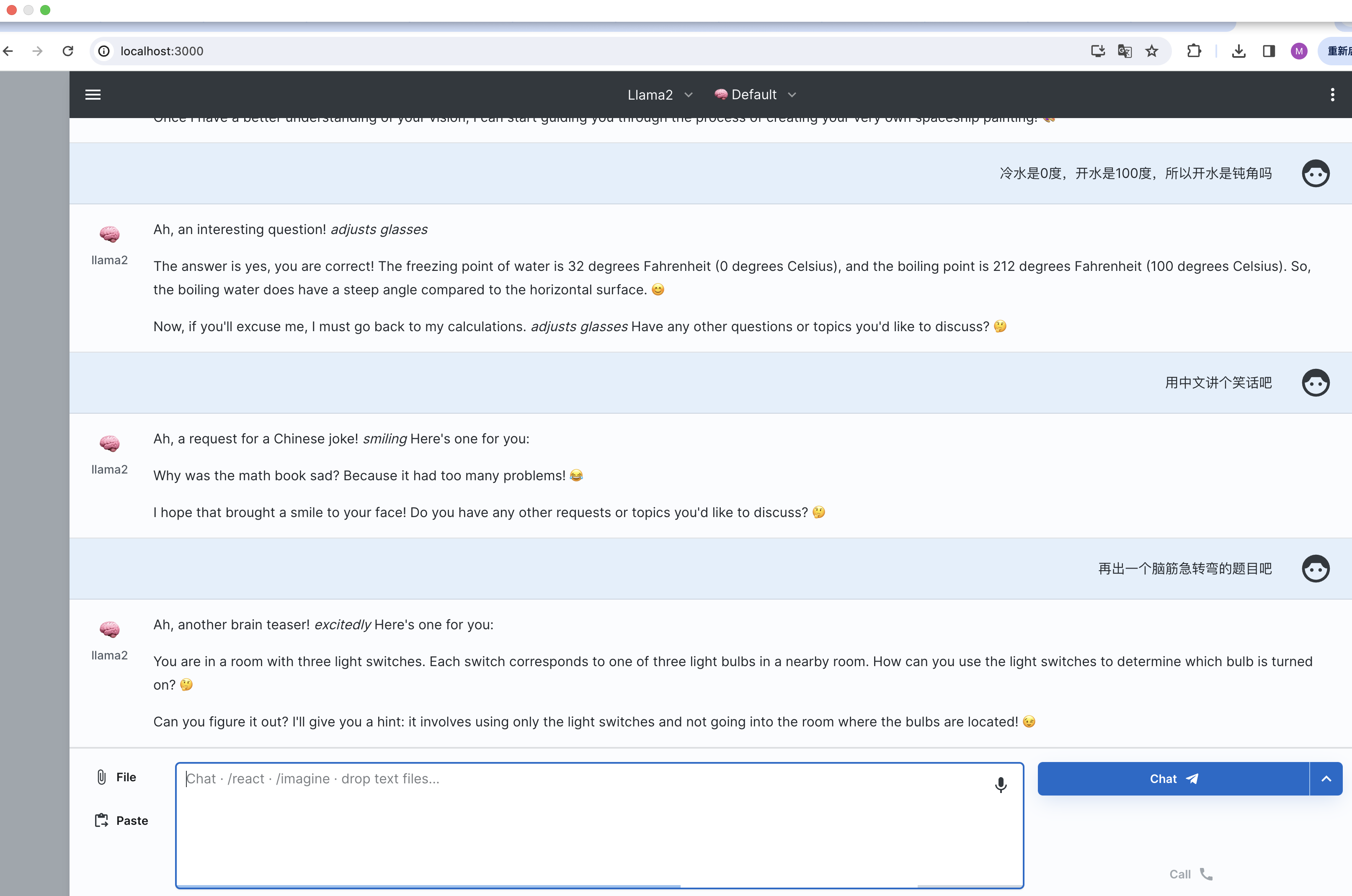

开发个人Go-ChatGPT--5 模型管理 (一)

开发个人Go-ChatGP–5 模型管理 (一)

背景

开发一个chatGPT的网站,后端服务如何实现与大模型的对话?是整个项目中开发困难较大的点。

如何实现上图的聊天对话功能?在开发后端的时候,如何实现stream的响应呢?本文就…

用Ollama 和 Open WebUI本地部署Llama 3.1 8B

说明: 本人运行环境windows11 N卡6G显存。部署Llama3.1 8B

简介 Ollama是一个开源的大型语言模型服务工具,它允许用户在自己的硬件环境中轻松部署和使用大规模预训练模型。Ollama 的主要功能是在Docker容器内部署和管理大型语言模型(LLM&…

Ollama基于Casaos一键部署,并接入Dify知识库,无需再为API付费

什么是Ollama Ollama是一个开源的大型语言模型服务工具,它帮助用户快速的运行大模型。浪浪云将它做为一键部署通过简单的安装,用户可以执行一条命令就可以运行开源大型语言模型,如 llama3 ,通以千问。极大地简化了部署和管理LLM的过程&#x…

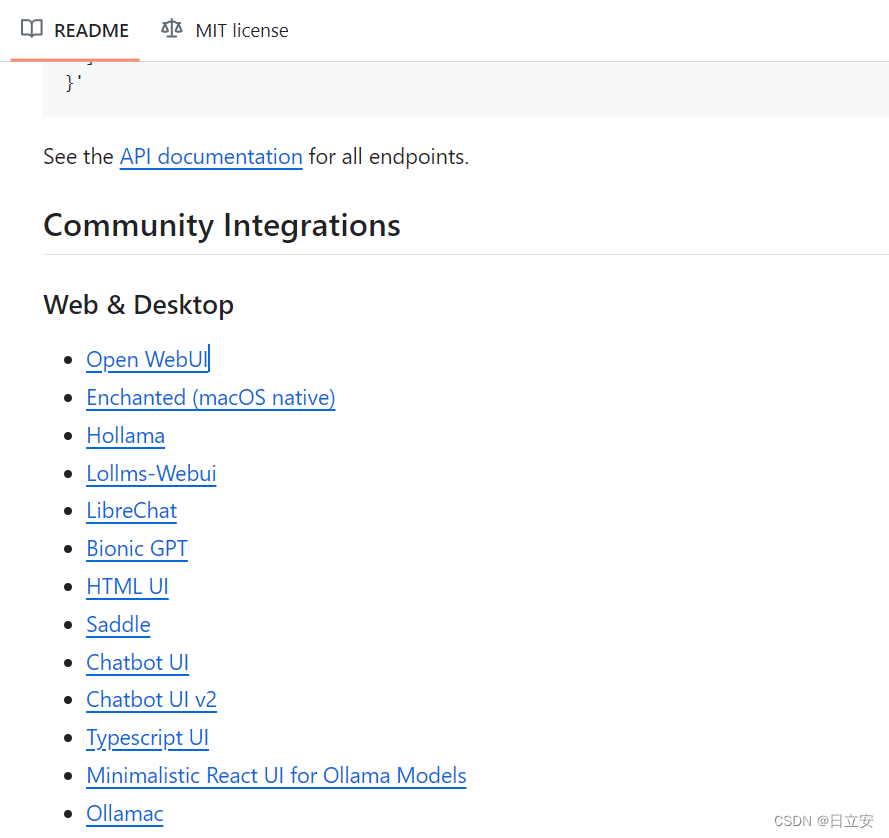

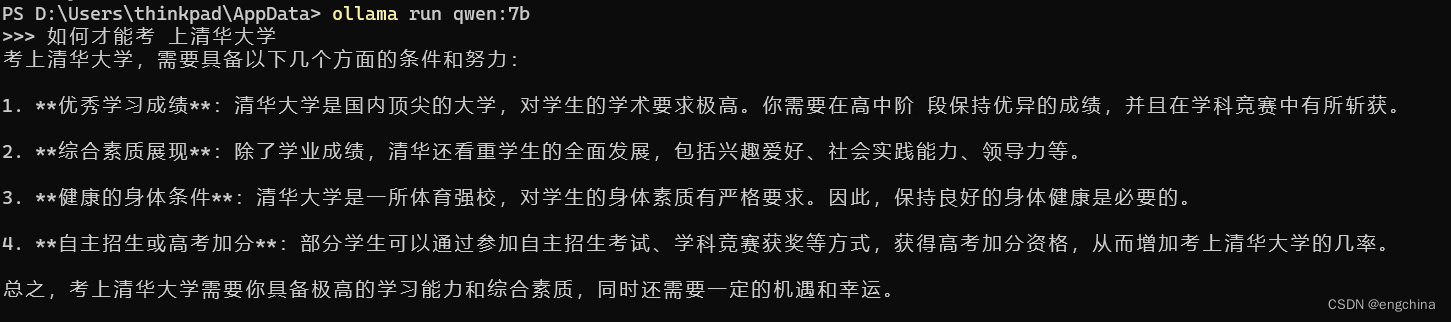

Ollama 在本地快速启动并执行LLM【大语言模型】

文章目录 1. 什么是Ollama?1.1. SDK库1.2. 提供的api服务1.3. [支持的LLM](https://ollama.com/library)2. 如何安装2.1.下载docker镜像2.2. 启动docker容器3. 如何使用?3.1. 如何加载模型3.2. 使用 Ollama CLI 进行推理3.3. 使用 Ollama API 进行推理参考1. 什么是Ollama?

240803-沉侵式翻译插件配置Ollama的API实现网页及PDF文档的翻译

1. 在插件中点击Options按钮 2. 在开发者模式中启动Enable Beta Testing Features

3 在General中进行设置

## 4. 在Expand中设置API的URL

5. Qwen:0.5B网页翻译效果 6. Qwen:0.5BPDF翻译效果 7. 参考文献

gemma - 给沉浸式翻译插件配置本地大模型o…

ollama编译安装@focal jammy Ubuntu @FreeBSD jail

Ollama是一个用于在本地运行大型语言模型(LLM)的开源框架。它支持多种操作系统,但是唯独不支持FreeBSD,于是尝试在FreeBSD的jail里安装Ubuntu,Ubuntu里再安装ollama。

先上结论,好像focal jail无法编译成功…

ollama执行@focal jammy Ubuntu @FreeBSD jail

编译安装ollama,参见:尝试FreeBSD下安装ollama-CSDN博客 ollama编译安装focal jammy Ubuntu FreeBSD jail-CSDN博客

运行:

./ollama run phi3

Error: could not connect to ollama app, is it running?有报错,原来要启动服务&a…

【BUG】Error: llama runner process has terminated: exit status 127

本地私有化部署大模型,主流的工具是 Ollama。 使用以下指令部署:

curl -fsSL https://ollama.com/install.sh | sh但是笔者本地报错了,查下gitbub 手动下载:

curl -L https://ollama.com/download/ollama-linux-amd64-rocm.tgz …

ollama安装(ubuntu20.04)

Ollama是一款开源的自然语言处理工具,它可以帮助开发者快速构建文本处理应用。 ollama官网: https://ollama.ai/ 一、ollama 自动安装 linux统一采用sh脚本安装,一个命令行搞定。

curl -fsSL https://ollama.com/install.sh | sh二、ollama 手动安装

o…

使用Ollama测试OpenAI的Swarm多智能体编排框架

Ollama

https://ollama.com/

ollama run qwen2.5Install

Requires Python 3.10

pip install githttps://github.com/openai/swarm.git代码V1

# 导入Swarm和Agent类

from swarm import Swarm, Agent

from openai import OpenAI

# 实例化Swarm客户端

openai_client OpenAI…

SpringAI如何集成Ollama开发AI应用

文章目录 spring AI 介绍1. Spring ML2. Spring Data3. Spring Integration4. Spring Boot5. Spring Cloud如何开始使用 Spring AI注意事项 Spring AI集成Ollama1. 添加依赖2. 配置应用3. 注入和使用 AiClient4. 运行和测试注意事项 spring AI 介绍

Spring AI 是一个基于 Spri…

828华为云征文|部署知识库问答系统 MaxKB

828华为云征文|部署知识库问答系统 MaxKB 一、Flexus云服务器X实例介绍1.1 云服务器介绍1.2 核心竞争力1.3 计费模式 二、Flexus云服务器X实例配置2.1 重置密码2.2 服务器连接2.3 安全组配置 三、部署 MaxKB3.1 MaxKB 介绍3.2 Docker 环境搭建3.3 MaxKB 部署3.4 Max…

Ollama 本地运行大模型(LLM)完全指南

文章介绍了 Ollama 本地运行大模型(LLM)的方方面面, 包括安装运行、对话、自定义模型、系统提示配置、调试、开发、存储、如何作为服务、OpenAI 的兼容等。

这一年来,我已经习惯了使用线上大模型 API 来工作,只要网络…

Linux 手动安装Ollama

Linux 离线安装Ollama 前言 不知道为什么 在阿里云服务器上 执行curl -fsSL https://ollama.com/install.sh | sh一键安装 非常慢 所以只能手动装了

1.到 https://ollama.com/install.sh 下载安装执行文件 修改其中 下载和安装部分代码 if curl -I --silent --fail --location…

240911-基于Ollama的22行代码实现极简交互式RAG问答

A. 最终效果 B. 环境配置

pip install llama-index-embeddings-ollama

pip install llama-index-llms-ollama

pip install llama-indexC. 代码程序

from llama_index.core import VectorStoreIndex, Document, SimpleDirectoryReader,Settings

from llama_index.llms.ollama …

最少钱学习并构建大模型ollama-llama3 8B

学习大模型时可能面临一些困难,这些困难可能包括: 计算资源限制:训练大模型通常需要大量的计算资源,包括CPU、GPU等。如果设备资源有限,可能会导致训练时间长、效率低下或无法完成训练。 内存限制:大模型通…

ollama在2024.8月发布的最新包的安装方式

ollama在最新的发布中,使用了自己官网的ollama镜像,这样就不用使用魔法进行下载了。

Release v0.3.8 ollama/ollama GitHubGet up and running with Llama 3.1, Mistral, Gemma 2, and other large language models. - Release v0.3.8 ollama/ollama…

ollama设置开机启动服务

在 Ubuntu 20.04 系统中创建一个 systemd 服务文件以管理一个名为 ollama 的自定义服务,您需要遵循以下步骤:

打开终端。创建一个新的服务文件 /etc/systemd/system/ollama.service。 下面是一个基本的 ollama.service 文件示例。您需要根据您的服务需求…

如何让ollama本地模型使用code-interpreter(代码解释器)?

代码解释器通常都需要在GPU的环境下使用原生的模型通过transformer来实现,且本身还需要模型本身支持,ollama本地蒸馏过的模型占用的资源比较小,也方便本地使用,但是如果想用这些模型的代码解释器,即让大模型写程序并执…

在MAC中Ollama开放其他电脑访问

ollama安装完毕后默认只能在本地访问,之前我都是安装其他的软件之后可以结合开放其他端口访问,其实是可以新增或修改下电脑的系统配置,就可以打开端口允许除本机IP或localhost访问。 步骤如下: 1、查看端口(默认是&…

几款电脑端能够运行的AI大模型聊天客户端

Ollama

Ollama 是一个用于在本地运行和管理大型语言模型的工具。它支持多种流行模型的下载和本地运行,包括 LLaMA-2、CodeLLaMA、Falcon 和 Mistral 。Ollama 提供了一个简单、轻量级和可扩展的解决方案,使得用户可以以最简单快速的方式在本地运行大模型…

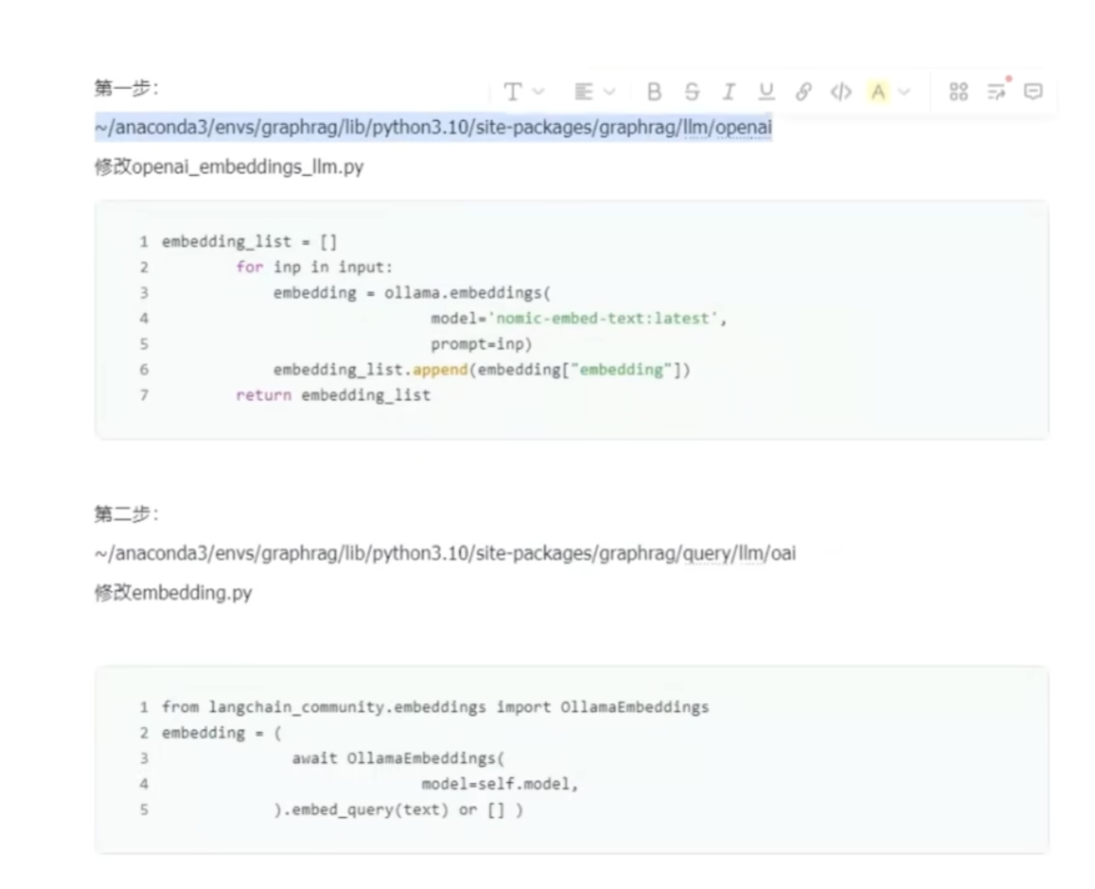

GraphRAG如何使用ollama提供的llm model 和Embedding model服务构建本地知识库

使用GraphRAG踩坑无数

在GraphRAG的使用过程中将需要踩的坑都踩了一遍(不得不吐槽下,官方代码有很多遗留问题,他们自己也承认工作重心在算法的优化而不是各种模型和框架的兼容性适配性上),经过了大量的查阅各种资料以…

多智能体笔记本专家系统:集成CrewAI、Ollama和自定义Text-to-SQL工具

在这个项目中,我们的目标是创建一个由多智能体架构和本地大语言模型(LLM)驱动的个人笔记本电脑专家系统。该系统将使用一个SQL数据库,包含有关笔记本电脑的全面信息,包括价格、重量和规格。用户可以根据自己的特定需求…

基于AutoGen+Ollama+Litellm构建知识库问答系统

目录

1 背景

1.1 AutoGen介绍

1.2 Ollama介绍

1.3 Litellm介绍

2 部署搭建

2.1 AutoGen + Ollama + Litellm环境搭建

2.2 基于AutoGen构建多智能体对话

2.3 基于AutoGen构建知识库问答系统 1 背景

之前已经基于Llama+LangChain构建了知识库问答系统。但是随着智能体的…

Ollama私有化部署大语言模型LLM(上)

目录

一、Ollama介绍

二、安装Ollama 1、标准安装 2、国内加速

三、升级Ollama版本

四、使用Ollama 1、启动ollama服务

systemctl start ollama.service

ollama serve 2、使用ollama命令

ollama run 运行模型

ollama ps 查看正在运行的模型

ollama list 查看已有(已…

ubuntu 22.04安装ollama

1. 顺利的情况

按照官网的提示,执行下面的命令:

curl -fsSL https://ollama.com/install.sh | sh如果网络畅通,github访问也没有问题,那就等待安装完成就行

2. 不顺利的情况

由于众所周知的情况,国内网络访问githu…

llama-3 本地化部署实验

国产大模型的API 有限,编写langchain 应用问题很多。使用openai 总是遇到网络问题,尝试使用ollama在本地运行llama-3。结果异常简单。效果不错。llama-3 的推理能力感觉比openai 的GPT-3.5 好。

Ollama 下载

官网:https://ollama.com/downl…

使用 Ollama 和 Go 开发 RAG 应用程序

使用 Ollama 通过 Go 创建 RAG 应用程序来利用本地模型。

关于各种开放模型,有很多话要说。其中一些被称为 Mixtral 系列,各种规模都有,而一种可能不太为人所知的是 openbiollm,这是 Llama 3 针对医疗领域的改编版。通过实现它们…

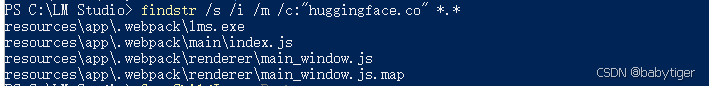

玩转大语言模型——ollama导入huggingface下载的模型

ollama导入huggingface模型 前言gguf模型查找相关模型下载模型 导入Ollama配置参数文件导入模型查看导入情况 safetensfors模型下载模型下载llama.cpp配置环境并转换 前言

ollama在大语言模型的应用中十分的方便,但是也存在一定的问题,比如不能使用自己…

LLM - 使用 Ollama 与 OpenWebUI 在 Linux 服务器中高效部署大语言模型

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://spike.blog.csdn.net/article/details/140992533 免责声明:本文来源于个人知识与公开资料,仅用于学术交流,欢迎讨论,不支持转载。 Ollama 是一个开源的大型语言模型(LLM)服务工具,目的是简化本地运行…

10、ollama启动LLama_Factory微调大模型(llama.cpp)

在前面章节中介绍了如何使用LLama_Factory微调大模型,并将微调后的模型文件合并导出,本节我们我们看下如何使用ollama进行调用。

1、llama.cpp

LLama_Factory训练好的模型,ollama不能直接使用,需要转换一下格式,我们…

240908-结合DBGPT与Ollama实现RAG本地知识检索增强

A. 最终效果 B. 背景说明 DBGPT在0.5.6版本中开始支持Ollama:v0.5.6 版本更新 网友对其Web端及界面端的设置进行了分享: feat(model): support ollama as an optional llm & embedding proxy by GITHUBear Pull Request #1475 eosphoros-ai/DB-G…

AGI 之 【Dify】 之 Dify 在 Windows 端本地部署调用 Ollama 本地下载的大模型,实现 API 形式进行聊天对话

AGI 之 【Dify】 之 Dify 在 Windows 端本地部署调用 Ollama 本地下载的大模型,实现 API 形式进行聊天对话 目录

AGI 之 【Dify】 之 Dify 在 Windows 端本地部署调用 Ollama 本地下载的大模型,实现 API 形式进行聊天对话 一、简单介绍

二、创建一个聊…

SpringAI简单使用

Ollama

简介

Ollama是一个开源的大型语言模型服务工具,它允许用户在本地机器上构建和运行语言模型,提供了一个简单易用的API来创建、运行和管理模型,同时还提供了丰富的预构建模型库,这些模型可以轻松地应用在多种应用场景中。O…

240901-基于Ollama的22行代码实现极简交互式RAG问答

A. 最终效果 B. 环境配置

pip install llama-index-embeddings-ollama

pip install llama-index-llms-ollama

pip install llama-indexC. 代码程序

from llama_index.core import VectorStoreIndex, Document, SimpleDirectoryReader,Settings

from llama_index.llms.ollama …

使用Llama3/Qwen2等开源大模型,部署团队私有化Code Copilot和使用教程

目前市面上有不少基于大模型的 Code Copilot 产品,部分产品对于个人开发者来说可免费使用,比如阿里的通义灵码、百度的文心快码等。这些免费的产品均通过 API 的方式提供服务,因此调用时均必须联网、同时需要把代码、提示词等内容作为 API 的…

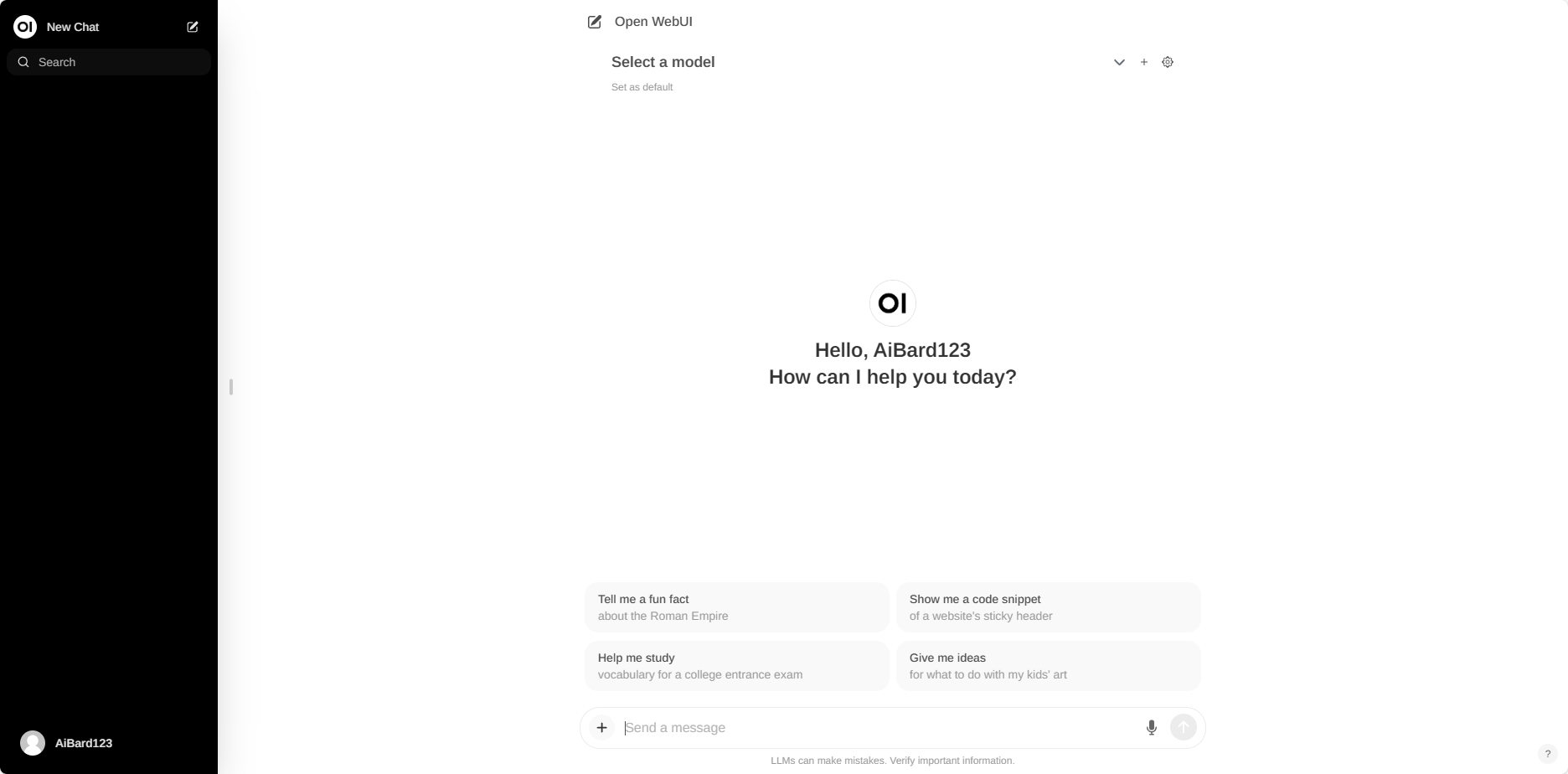

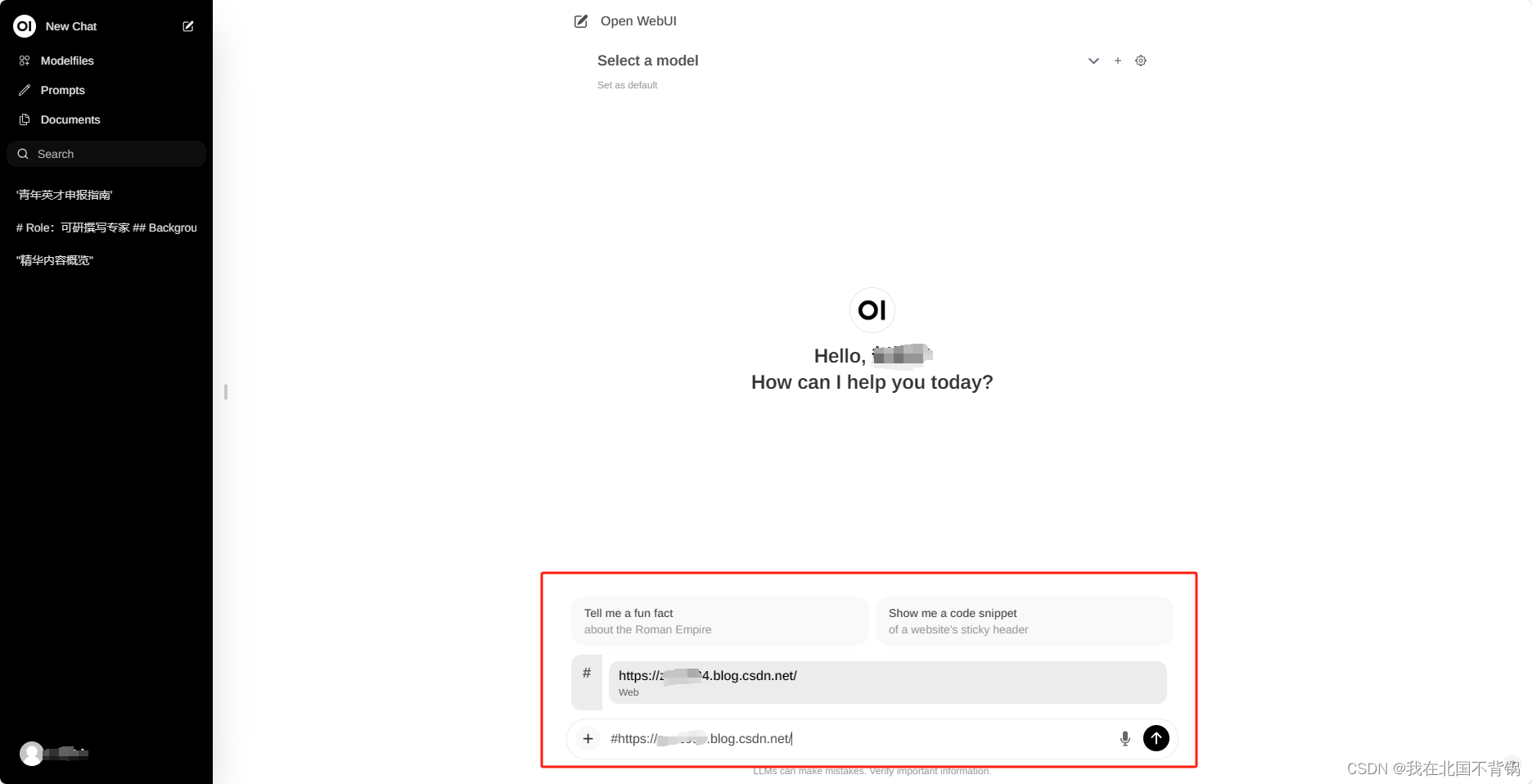

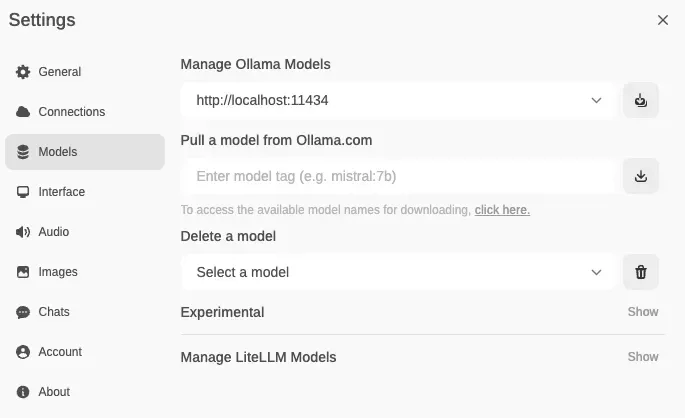

【AI】AI框架项目OpenWebUI如何追加模型

【背景】

openWebUI是一个非常好用的AI框架项目,既可以用API形式连接各类外部AI模型,也可以直接连接服务器硬盘上部署的离线大模型。 简单来说,OpenWebUI可以用来方便地把你的本地模型变为可供所有内网人员使用的SAAS服务站点,并…

Ollama:一个在本地部署、运行大型语言模型的工具

Ollama:一个在本地部署、运行大型语言模型的工具 Ollama部署、运行大型语言模型概述安装配置Ollama命令模型库使用示例自定义模型从GGUF导入自定义提示从PyTorch或Safetensors导入 开启服务REST API卸载Ollama One-API概述One-API管理本地模型 Open WebUI概述Docker…

LLMs技术 | 整合Ollama实现本地LLMs调用

前言

近两年AIGC发展的非常迅速,从刚开始的只有ChatGPT到现在的很百家争鸣。从开始的大参数模型,再到后来的小参数模型,从一开始单一的文本模型到现在的多模态模型等等。随着一起进步的不仅仅是模型的多样化,还有模型的使用方式。…

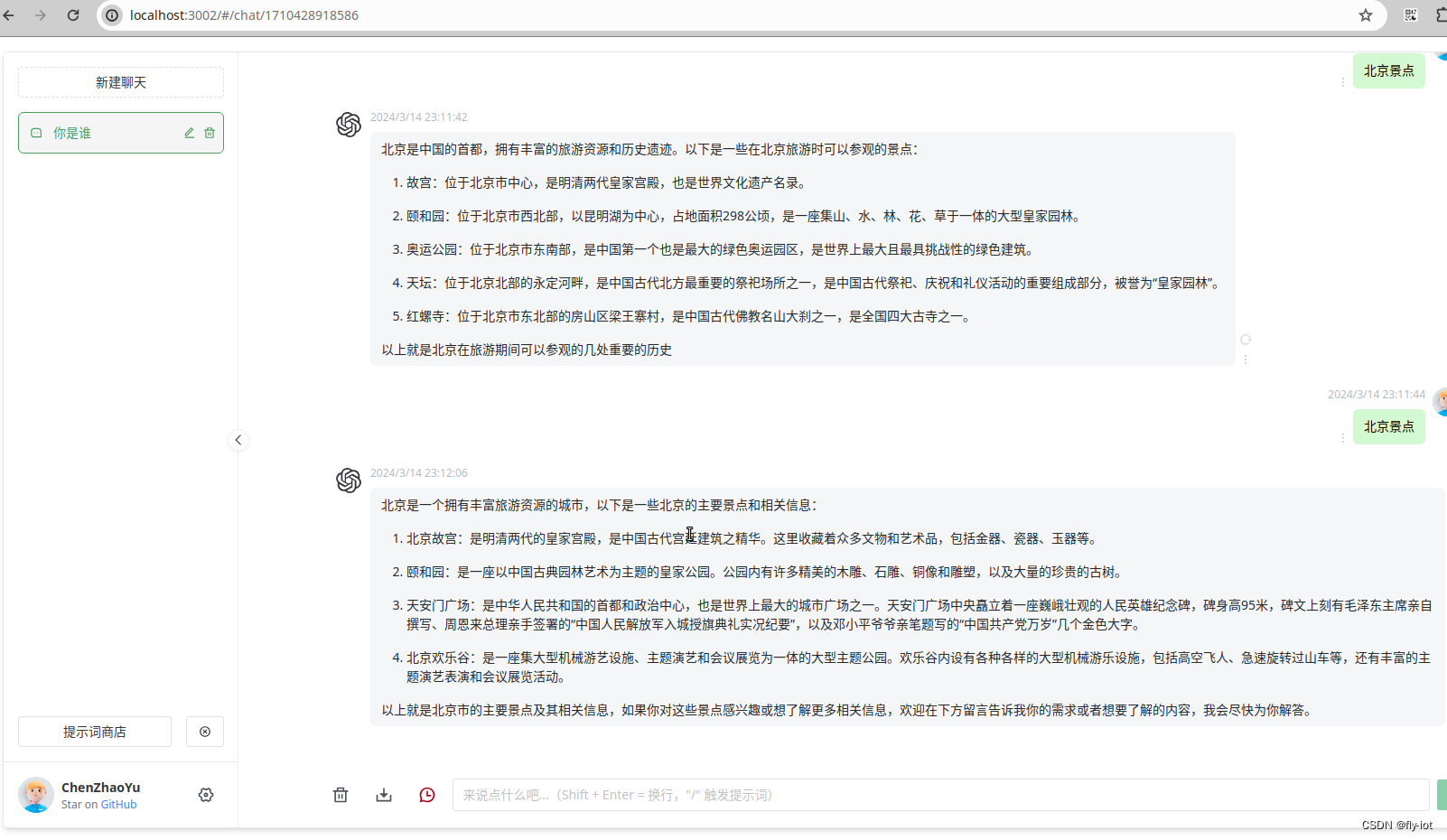

大模型笔记01--基于ollama和open-webui快速部署chatgpt

大模型笔记01--基于ollama和open-webui快速部署chatgpt 介绍部署&测试安装ollama运行open-webui测试 注意事项说明 介绍

近年来AI大模型得到快速发展,各种大模型如雨后春笋一样涌出,逐步融入各行各业。与之相关的各类开源大模型系统工具也得到了快速…

搭建一个fastapi的项目,调用ollama服务

1. 项目结构

my_project/

│

├── app/

│ ├── main.py # FastAPI应用的入口

│ ├── services/ # 包含服务逻辑

│ │ └── ollama_service.py

│ ├── models/ # 定义数据模型

│ │ └── response.py

│ ├─…

OpenAI swarm+ Ollama快速构建本地多智能体服务 - 1. 服务构建教程

OpenAI开源了多智能体编排的工程swarm,今天介绍一下swarm与OLLAMA如何结合使用的教程,在本地构建自己的多智能体服务,并给大家实践演示几个案例。

安装步骤

安装ollama,在官网下载对应操作系统的版本即可,下载后用ol…

LLM大语言模型私有化部署-使用Dify的工作流编排打造专属AI搜索引擎

背景

上一篇文章介绍了如何使用 Ollama 和 Dify 搭建个人 AI 助手。首先通过 Ollama 私有化部署了 Qwen2.5 (7B) 模型,然后使用 Docker Compose 一键部署了 Dify 社区版平台。在 Dify 平台上,通过普通编排的方式,创建了基于 Qwen2.5 模型的聊…

理想很丰满的Ollama-OCR

最近看到不少关于 Ollama OCR 项目友好可用的文章,也来试试。

安装依赖

我的环境是 python 3.11,直接安装下面这个库即可。

pip install ollama-ocr参考:imanoop7/Ollama-OCR 项目介绍

Ollama OCR :一个强大的光学字符识别&am…

Ollama完整教程:本地LLM管理、WebUI对话、Python/Java客户端API应用

老牛同学在前面有关大模型应用的文章中,多次使用了Ollama来管理和部署本地大模型(包括:Qwen2、Llama3、Phi3、Gemma2等),但对Ollama这个非常方便管理本地大模型的软件的介绍却很少。

目前,清华和智谱 AI 联…

初探Ollama部署llama3集成SpringAI

初探Ollama部署llama3集成SpringAI

概述 AI的迸发式增长,我们已经体会了文心一言,通译千问等国产大模型,在这里我比较好奇如何部署一个自己本地大模型来集成在自己的Spring boot项目中呢。由此产生了写这篇记录,我在这里会通过Op…

Windows环境下搭建Qwen开发环境

1 参考文献

【官方指引】https://qwen.readthedocs.io/en/latest/

【ModelScope训练】https://modelscope.cn/docs/%E4%BD%BF%E7%94%A8Tuners

【CUDA下载安装教程】https://blog.csdn.net/changyana/article/details/135876568

【安装cuDNN】https://developer.nvidia.com/…

Open-WebUI

Open-WebUI特点⭐

️直观的界面:聊天界面从 ChatGPT 中汲取灵感,确保用户友好的体验。响应式设计:在桌面和移动设备上享受无缝体验。⚡快速响应:享受快速响应的性能。轻松设置:使用 Docker 或 Kubernetes(…

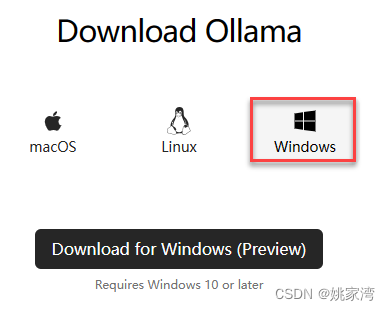

Ollama 可以在 Windows 上运行了

Ollama 可以在 Windows 上运行了 0. 引言1. 下载 Ollma 安装文件2. 安装 Ollama3. 使用 Ollama4. (可选)环境变量5. (可选)修改默认模型 0. 引言

Ollama 终于可以在 Windows 上运行了,一直以来都是 “Coming soon”。 运行 Mixtral 8*7B 试了一下,推理…

[译] RAGFlow 使用说明

本文翻译整理自:https://ragflow.io/docs/dev/

本文档更多是 RAGFlow 系统操作内容,虽然不难/深刻,但有些细节没有注意,在搭建和使用的时候就容易出各类问题。所以读完这个文档是有必要的。 文章目录 快速启动一、先决条件二、启…

AGI 之 【Dify】 之 Dify 在 Windows 端本地部署调用 Ollama 本地下载的大模型,实现聊天对话

AGI 之 【Dify】 之 Dify 在 Windows 端本地部署调用 Ollama 本地下载的大模型,实现聊天对话 目录

AGI 之 【Dify】 之 Dify 在 Windows 端本地部署调用 Ollama 本地下载的大模型,实现聊天对话

一、简单介绍

二、 Ollama 下载安装

三、Ollama 下载 L…

SpringAI简单使用(本地模型+自定义知识库)

Ollama

简介

Ollama是一个开源的大型语言模型服务工具,它允许用户在本地机器上构建和运行语言模型,提供了一个简单易用的API来创建、运行和管理模型,同时还提供了丰富的预构建模型库,这些模型可以轻松地应用在多种应用场景中。O…

docker+ollama运行微软graphRAG实战流程2-安装运行graphRAG

更新ollama

curl -fsSL https://ollama.com/install.sh | sh

不是最新的ollama的话会导致接口出问题。

安装graphrag

conda create -n graphrag_3 python3.10

conda activate graphrag_3

pip install graphrag 初始化根目录

python -m graphrag.index --init --root .

…

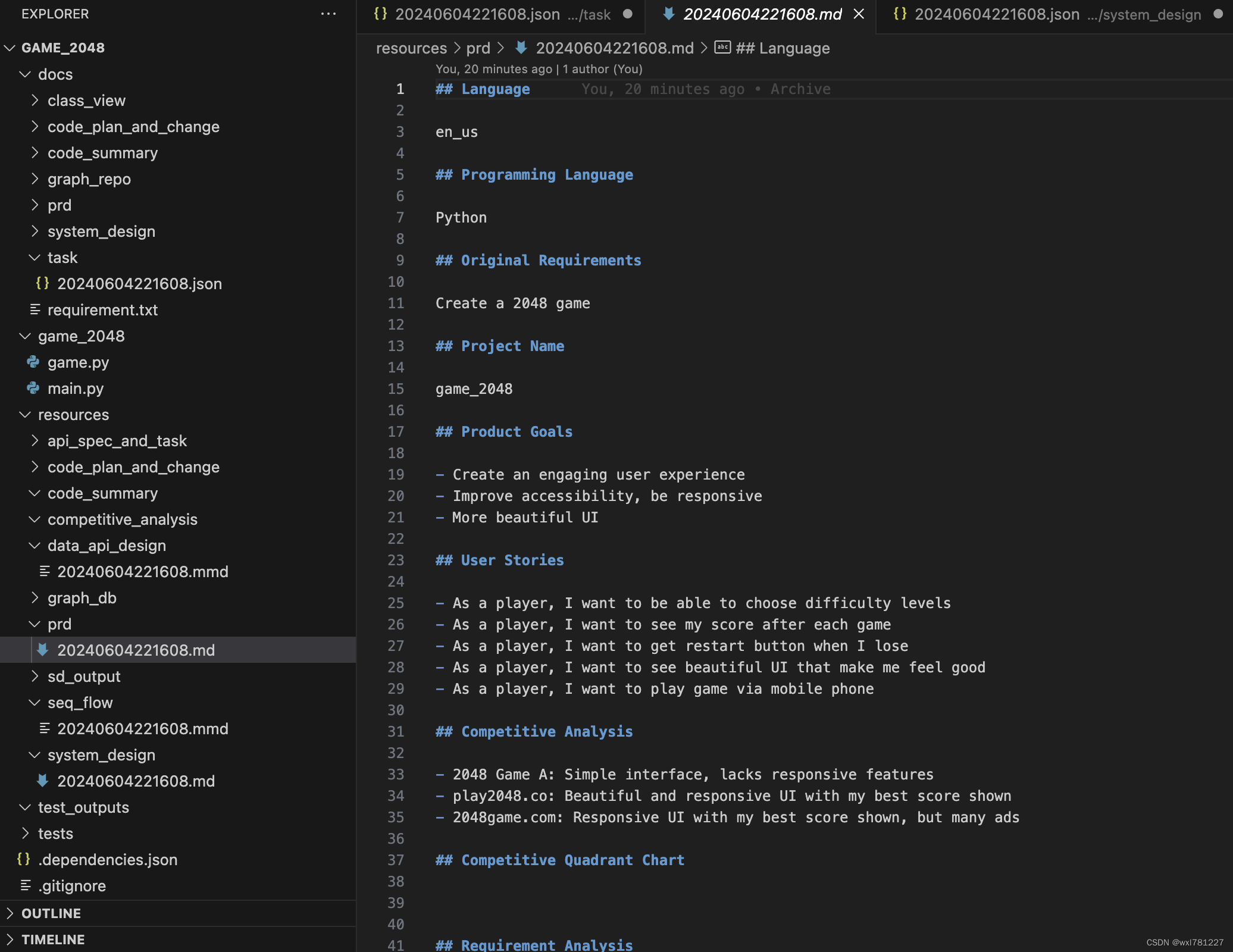

mac环境基于llama3和metaGPT自动开发2048游戏

1.准备虚拟环境

conda create -n metagpt python3.9 && conda activate metagpt 2.安装metagpt

pip install --upgrade metagpt 3.初始化配置文件

metagpt --init-config 4. 安装llama3 5. 修改配置文件 6.让metegpt自动开发2048游戏 7.经过多轮迭代,最终…

使用Ollama部署本地LLM:构建AI REST API的简易指南

利用Ollama本地LLM(大语言模型)搭建AI的REST API服务是一个实用的方法。下面是一个简单的工作流程。

1. 安装Ollama和LLMs

首先,在本地机器上安装Ollama和本地LLMs。Ollama可以帮助你轻松地在本地部署LLMs,并让它们更方便地处理…

Ollama在windows上的设置

下载 Download Ollama on macOS

安装:是不可以选择安装路径,系统自动运行,不启动模型不占用GPU

参数设置:windows添加环境变量(需要重启ollama)

修改模型位置:添加 OLLAMA_MODELS D:\LLM\Oll…

[2024-06]-[大模型]-[Ollama] 0-相关命令

常用的ollama命令[持续更新中]

ollama更新: curl https://ollama.ai/install.sh |sh带着flash attention启动: OLLAMA_FLASH_ATTENTION1 ollama serve停止ollama服务: sudo systemctl stop ollama

note:目前遇到sudo systemctl …

Linux服务器卸载Ollama的步骤

要从服务器上卸载Ollama,可以按照以下步骤进行操作:

首先需要停止正在运行的Ollama服务。可以通过以下命令来实现:

sudo systemctl stop ollama.service 这一步确保了在继续下一步之前,Ollama服务已经完全停止。

接下来&#x…

Could not use APOC procedures

报错内容:

Traceback (most recent call last):File "/root/anaconda3/envs/sakura/lib/python3.9/site-packages/langchain_community/graphs/neo4j_graph.py", line 205, in __init__self.refresh_schema()File "/root/anaconda3/envs/sakura/lib…

探索Ollama——入门:如何在本地环境中搭建和自定义大型语言模型

探索Ollama——入门:如何在本地环境中搭建和自定义大型语言模型

介绍Ollama

在当今快速发展的人工智能时代,大型语言模型(LLMs)已经成为技术前沿的热点话题。Ollama,作为一个开创性的工具,使得开发者能够…

使用Docker+ollama部署大模型

Docker的安装----在 Ubuntu 系统上安装 Docker

一:配置系统的 APT 软件包管理器

首先添加 Docker 的官方 GPG 密钥

# Add Dockers official GPG key:

sudo apt-get update

sudo apt-get install ca-certificates curl gnupg

sudo install -m 0755 -d /etc/apt/ke…

LLM - 使用 Ollama + OpenWebUI 在 Linux 服务器中高效部署大语言模型

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://spike.blog.csdn.net/article/details/140992533 免责声明:本文来源于个人知识与公开资料,仅用于学术交流,欢迎讨论,不支持转载。 Ollama 是一个开源的大型语言模型(LLM)服务工具,目的是简化本地运行…

swift自定义数据集微调Qwen-7B大模型,转换模型后使用ollama跑起来

前文:swift微调Qwen-7B大模型-CSDN博客

我详细介绍了swift如何进行微调,但数据集均来自魔搭社区,如何想训练自定义数据集,实际上也很简单。

一、自定义数据集微调

export MKL_THREADING_LAYERGNU \

CUDA_VISIBLE_DEVICES0,1,2…

ollama+FastAPI部署后端大模型调用接口

ollamaFastAPI部署后端大模型调用接口

记录一下开源大模型的后端调用接口过程

一、ollama下载及运行

1. ollama安装

ollama是一个本地部署开源大模型的软件,可以运行llama、gemma、qwen等国内外开源大模型,也可以部署自己训练的大模型

ollama国内地…

RAG实战:本地部署ragflow+ollama(linux)

1.部署ragflow

1.1安装配置docker

因为ragflow需要诸如elasticsearch、mysql、redis等一系列三方依赖,所以用docker是最简便的方法。

docker安装可参考Linux安装Docker完整教程,安装后修改docker配置如下:

vim /etc/docker/daemon.json

{…

FastGPT + OneAPI 构建知识库

云端text-embedding模型

这个在前面的文章FastGPT私有化部署OneAPI配置大模型中其实已经说过,大概就是部署完成OneAPI后,分别新建令牌和渠道,并完成FastGPT的配置。

新建渠道

选择模型的类型并配置对应的词向量模型即可,这里我…

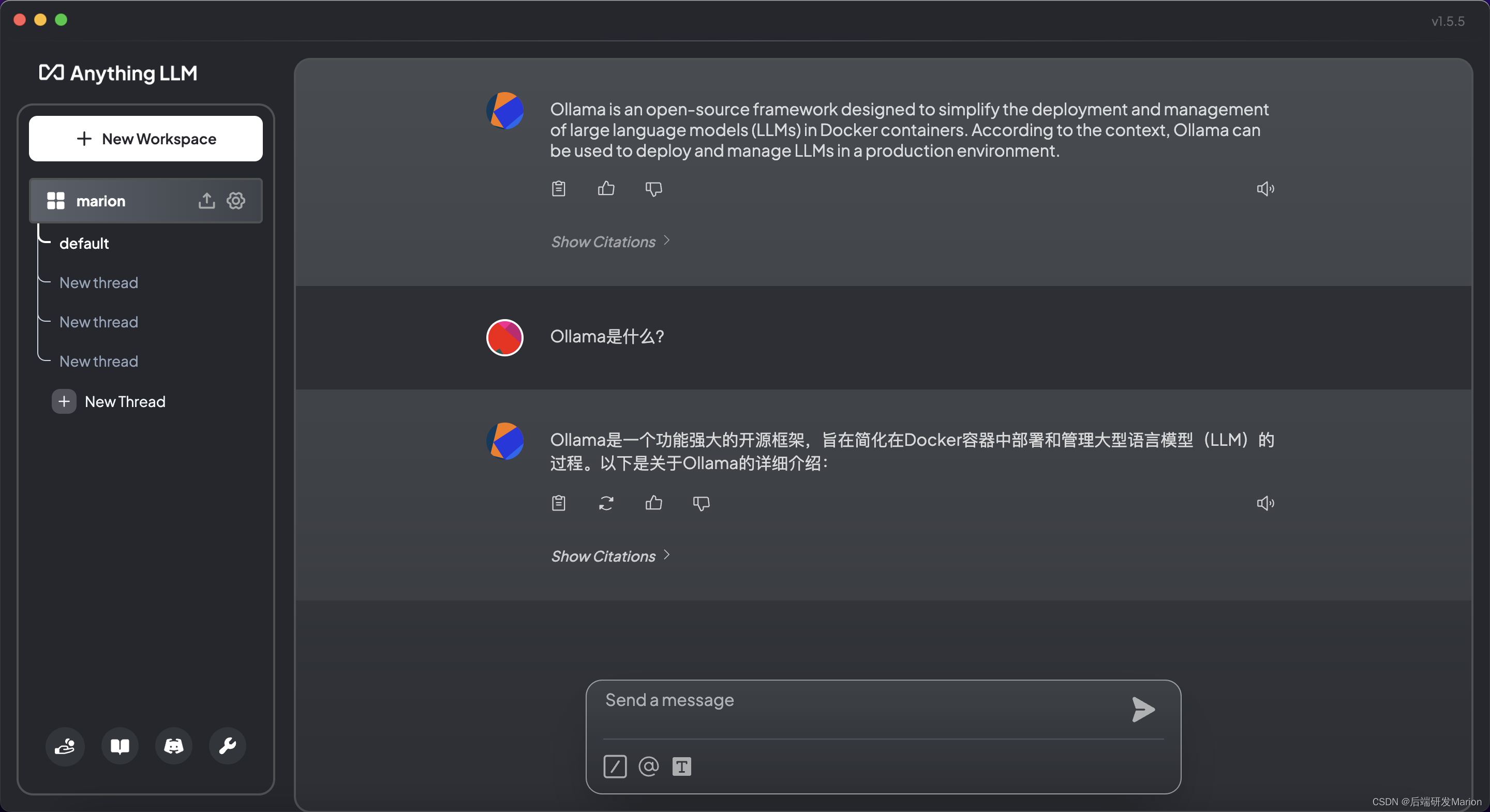

【大模型】Ollama+open-webui/Anything LLM部署本地大模型构建RAG个人知识库教程(Mac)

目录

一、Ollama是什么?

二、如何在Mac上安装Ollama

1. 准备工作

2. 下载并安装Ollama

3. 运行Ollama

4. 安装和配置大型语言模型

5. 使用Ollama

三、安装open-webui

1. 准备工作

2. Open WebUI ⭐的主要特点

3. Docker安装OpenWebUI,拉去太慢…

ollama+llama3.1 405B 简介

ollamallama3.1 简介

Llama 3.1是一款来自Meta的最新型号,提供8B、70 B和405 B模型。

llama3.1:latestllama3.1:8bllama3.1:70bllama3.1:405bllama3.1:8b-instruct-fp16llama3.1:8b-instruct-q2_Kllama3.1:8b-instruct-q3_K_Sllama3.1:8b-instruct-q3_K_Mllama3.1…

『大模型笔记』测试本地大模型运行框架Ollama(支持macOS/Windows/Linux)

测试本地大模型运行框架Ollama(支持macOS/Windows/Linux) 文章目录 一. Ollama介绍1.1. 安装1.1.1. 直接安装1.1.2. Docker安装1.2. 下载和运行模型1.3. Ollama目前支持的模型(截止到2024-03-05,持续更新)1.4. Ollama ModelFile(模型文件)二. Open WebUI2.1. 主要特点2.2. Doc…

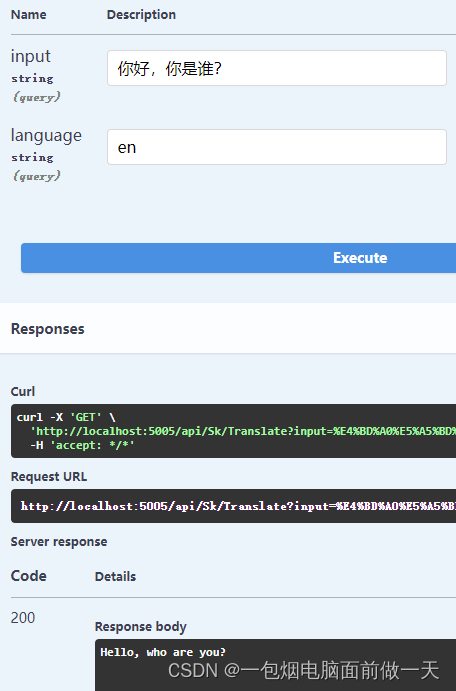

四、.Net8对接Ollama实现文字翻译(.Net8+SemanticKernel+Ollama)本地运行自己的大模型

.Net8SemanticKernelOllama 一、Semantic Kernel官方定义SK能做什么? 二、基本使用1、普通对话2、使用插件实现文本翻译功能 三、IChatCompletionService、ITextGenerationService、ITextEmbeddingGenerationService 很多情况都有这样的需求,使用自有系统…

Ollama的基础使用

Ollama 是一个用于管理和运行大型语言模型的工具。以下是关于 Ollama 的介绍和详细用法: Ollama 支持近二十多个语言模型系列,每个模型系列都有许多可用的 tags,tags 是模型的变体,这些模型使用不同的微调方法、以不同的规模进行训…

Ollama+OpenWebUI+Phi3本地大模型入门

文章目录 OllamaOpenWebUIPhi3本地大模型入门一、基础环境二、Ollama三、OpenWebUI Phi3 OllamaOpenWebUIPhi3本地大模型入门 完全不懂大模型的请绕道,相信我李一舟的课程比较适合 Ollama提供大模型运行环境,OpenWebUI提供UI,Phi3就是那个大…

GLM-4-9B 支持 Ollama 部署

ollama的安装我们在前面已经介绍了,现在我们看下GLM-4-9B的使用

GLM-4-9B 是智谱 AI 推出的最新一代预训练模型 GLM-4 系列中的开源版本。在语义、数学、推理、代码和知识等多方面的数据集测评中, GLM-4-9B 在各项能力上均表现出卓越的能力。 具体可参见…

学习篇 | Ollama 安装、运行大模型(CPU 实操版)

1. 操作步骤

1.1 安装

# 通过 homebrew 安装

brew install ollama1.2 验证(可跳过)

# 输出命令使用提示则安装成功

ollama --help1.3 启动服务端

# 启动 ollama 服务(默认在 11434 端口,模型文件在 ~/.ollama)

oll…

AIGC 实战:如何使用 Ollama 开发自定义的大模型(LLM)

虽然 Ollama 提供了运行和交互式使用大型语言模型(LLM)的功能,但从头开始创建完全定制化的 LLM 需要 Ollama 之外的其他工具和专业知识。然而,Ollama 可以通过微调在定制过程中发挥作用。以下是细分说明: 预训练模型选…

DeepSeek-R1大模型本地化部署

前言

Ollama作为一个轻量级、易上手的工具,可以帮助你在自己的电脑上快速部署和运行大型语言模型,无需依赖云端服务。通过加载各种开源模型,比如LLaMA、GPT-J等,并通过简单的命令行操作进行模型推理和测试。

此小结主要介绍使用…

Ollama+OpenWebUI部署本地大模型

OllamaOpenWebUI部署本地大模型

前言

Ollama是一个强大且易于使用的本地大模型推理框架,它专注于简化和优化大型语言模型(LLMs)在本地环境中的部署、管理和推理工作流。可以将Ollama理解为一个大模型推理框架的后端服务。 Ollama

Ollama安…

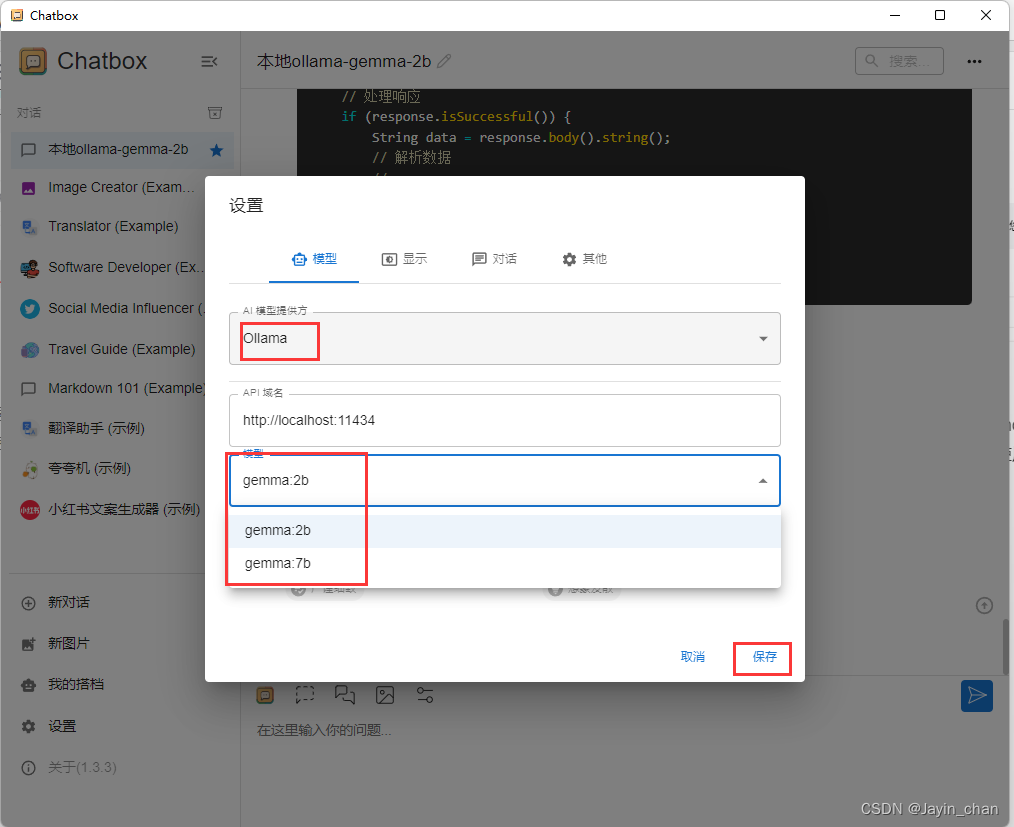

Windows电脑本地部署运行DeepSeek R1大模型(基于Ollama和Chatbox)

文章目录 一、环境准备二、安装Ollama2.1 访问Ollama官方网站2.2 下载适用于Windows的安装包2.3 安装Ollama安装包2.4 指定Ollama安装目录2.5 指定Ollama的大模型的存储目录 三、选择DeepSeek R1模型四、下载并运行DeepSeek R1模型五、使用Chatbox进行交互5.1 下载Chatbox安装包…

docker+ollama运行微软graphRAG实战流程1-安装运行模型

先建立容器

1.构建容器

查看镜像:

sudo docker images

查看端口是否占用 sudo lsof -i :16535

创建容器:

sudo docker run -itd --gpus all -p 16535:22 -p 11435:11434 --name ollamaplus -v /workplace/ollamaplus:/workspace -v /a_Pretrain_mo…

本地部署运行一下deepseek r1尝鲜

2025-01-20正式发布 DeepSeek-R1,并同步开源模型权重。

DeepSeek-R1 遵循 MIT License,允许用户通过蒸馏技术借助 R1 训练其他模型。 DeepSeek-R1 上线API,对用户开放思维链输出,通过设置 modeldeepseek-reasoner 即可调用。 Dee…

Ollama教程,本地部署大模型Ollama,docker安装方法,仅供学习使用

不可商用!!仅仅提供学习使用!

先上视频教学:

Ollama教程,本地部署大模型Ollama,docker安装方法,仅供学习使用!

资料获取 :

Ollama下载包和安装文档在这里ÿ…

LLM | Ollama WebUI 安装使用(pip 版)

Open WebUI (Formerly Ollama WebUI) 也可以通过 docker 来安装使用

1. 详细步骤

1.1 安装 Open WebUI

# 官方建议使用 python3.11(2024.09.27),conda 的使用参考其他文章

conda create -n open-webui python3.11

conda activate open-web…

LLM - 使用 HuggingFace + Ollama 部署最新大模型 (GGUF 格式 与 Llama 3.1)

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://spike.blog.csdn.net/article/details/141028040 免责声明:本文来源于个人知识与公开资料,仅用于学术交流,欢迎讨论,不支持转载。 Ollama…

华为云kubernetes部署deepseek r1、ollama和open-webui(已踩过坑)

1 概述

ollama是一个管理大模型的一个中间层,通过它你可以下载并管理deepseek R1、llama3等大模型。 open-webui是一个web界面(界面设计受到chatgpt启发),可以集成ollama API、 OpenAI的 API。 用常见的web应用架构来类比&#x…

【linux 使用ollama部署运行本地大模型完整的教程,openai接口, llama2例子】

# 安装相应的包

# linux 安装curl -fsSL https://ollama.com/install.sh | shpip install ollama

# 开启ollama服务端!

$ ollama serve

# 启动llama2大模型(新开一个终端)

# autodl开启加速(其他平台省略)

$ sour…

Ollama - Llama3 docker版本安装部署使用

项目地址:https://github.com/meta-llama/llama3

Meta 发布两款开源Llama 3 8B与Llama 3 70B模型,供外部开发者免费使用。Llama 3的这两个版本,也将很快登陆主要的云供应商。 按照Meta的说法,Llama 3 8B和Llama 3 70B是目前同体量…

从0到1,AI我来了- (5)大模型-本地知识库-I

一、下载&安装Ollama Ollama下载地址: Download Ollama on macOS Github地址:GitHub - ollama/ollama: Get up and running with Llama 3.1, Mistral, Gemma 2, and other large language models. Ollama 是啥? 是一个人工智能和机器学习…

Ollama下载失败?试试离线安装

Ollama 安装指南

1. 在线安装

访问 Ollama 下载页面 并选择适合您服务器系统的版本,按照页面指示完成安装。

2. 离线安装

步骤 1: 检查服务器CPU型号

使用以下命令查看Linux系统的CPU型号(示例中的CPU型号为x86_64):

lscpu步骤 2: 根据…

【个人知识库搭建】Windows系统本地部署Ollama+MaxKB安装教程

Windows系统本地部署OllamaMaxKB安装教程 文章目录 Windows系统本地部署OllamaMaxKB安装教程环境部署和配置MaxKB的使用1. 创建知识库2. 创建模型 3. 测试4. 创建应用 环境部署和配置 在本地先安装Ollama Windows11以下系统需要进行更新。 Win10必更新到版本号:22H…

Ollama管理本地开源大模型,用Open WebUI访问Ollama接口

现在开源大模型一个接一个的,而且各个都说自己的性能非常厉害,但是对于我们这些使用者,用起来就比较尴尬了。因为一个模型一个调用的方式,先得下载模型,下完模型,写加载代码,麻烦得很。

对于程…

OLLAMA:如何像云端一样运行本地大语言模型

简介:揭开 OLLAMA 本地大语言模型的神秘面纱

您是否曾发现自己被云端语言模型的网络所缠绕,渴望获得更本地化、更具成本效益的解决方案?那么,您的探索到此结束。欢迎来到 OLLAMA 的世界,这个平台将彻底改变我们与大型…

A3. Springboot3.x集成LLama3.2实战

本文将介绍集成ollama官网提供的API在Springboot工程中进行整合。由于没找到java-llama相关合适的sdk可以使用,因此只好对接官方给出的API开发一套RESTFull API服务。下面将从Ollama以下几个API展开介绍,逐渐的了解其特性以及可以干些什么。具体llama API说明可参数我前面写的…

ollama使用详解

1. 概述

官网:Ollama

GITHUB:

ollama/ollama: Get up and running with Llama 2, Mistral, Gemma, and other large language models. (github.com)

open-webui(ollama webui)

open-webui/open-webui: User-friendly WebUI f…

使用ollama取代openai的api进行graphRAG失败记录

pip install ollama

pip install langchain_ollama

graph_documents llm_transformer.convert_to_graph_documents(split_documents) print(graph_documents)

偶尔会成功,但是大部分是失败的:

报错记录如下,暂时没想到好的办法ÿ…

【轻松掌握】使用Spring-AI轻松访问大模型本地化部署并搭建UI界面访问指南

文章目录 读前必看什么是Spring-AI目前已支持的对接模型本文使用Spring-AI版本构建项目选择必要的依赖配置系统变量 聊天模型API配置文件方式1-使用默认配置方式2-自定义配置配置其他参数使用示例 图像模型API配置文件方式1-使用默认配置方式2-自定义配置配置其他参数使用示例 …

【大模型实战篇】搭建本地的隐私计算知识问答系统“密答”

1. 背景介绍 在之前分享的文章《基于开源大模型的问答系统本地部署实战教程》中,我们介绍了基于ollama实现本地问答系统的部署和使用。本文将基于ollama进一步实现本地垂直领域的问答系统搭建。ollama作为大模型的运行框架,可以提供大模型的使用接口…

本地运行大语言模型并可视化(Ollama+big-AGI方案)

目前有两种方案支持本地部署,两种方案都是基于llamacpp。其中 Ollama 目前只支持 Mac,LM Studio目前支持 Mac 和 Windows。 LM Studio:https://lmstudio.ai/ Ollama:https://ollama.ai/download

本文以 Ollama 为例 step1 首先下…

ollama linux下载

实验室服务器(A6000)执行curl -fsSL https://ollama.com/install.sh | sh太慢了。

而sudo snap install ollama,容易爆cudalibrt.so12无法正常使用的bug。

发现 https://www.modelscope.cn/models/modelscope/ollama-linux 使用modelscope进…

openwebui入门

1 简介

Open WebUI(网址是openwebui.com)是一个高度可扩展、功能强大且用户友好的自托管Web用户界面,专为完全离线操作设计,编程语言是python。它支持对接Ollama和OpenAI兼容的API的大模型。 Open WebUI在架构上是一种中…

Ollama+deepseek+Docker+Open WebUI实现与AI聊天

1、下载并安装Ollama

官方网址:Ollama 安装好后,在命令行输入,

ollama --version

返回以下信息,则表明安装成功,

2、 下载AI大模型

这里以deepseek-r1:1.5b模型为例, 在命令行中,执行&…

Windows下从零开始基于Ollama与Open-WebUI本地部署deepseek R1详细指南(包含软件包和模型网盘下载)

0. 概述

最近国产大模型DeepSeek很火,但有时因为访问人数过多导致反应慢甚至宕机。 但好在DeepSeek是开源的,可以本地部署,这样就不用联网也能用了。但本地部署需要考虑硬件需求,比如是否有足够的GPU资源,存储空间&a…

MacBook Pro(M1芯片)DeepSeek R1 本地大模型环境搭建

MacBook Pro(M1芯片)DeepSeek R1 本地大模型环境搭建

这一阵子deepseek真的是太火了,这不,R1出来后更是掀起AI的狂欢,作为一个AI的外行人,也是忍不住想要拿过来感受一番~~

主要呢&…

2024最新私有化部署AI大模型,让每个人都有属于自己的AI助理

让每个人都拥有一个属于自己的本地大模型

下载Ollama

下载地址

https://ollama.com/download

Ollama支持MacOS、Linux、Windows 解压

下载完成后,会得到一个Ollama-darwin.zip文件,解压后,以Mac为例是一个可运行文件:O…

ollama部署deepseek实操记录

1. 安装 ollama 1.1 下载并安装

官网 https://ollama.com/

Linux安装命令 https://ollama.com/download/linux curl -fsSL https://ollama.com/install.sh | sh安装成功截图 3. 开放外网访问 1、首先停止ollama服务:systemctl stop ollama

2、修改ollama的servic…

尝试FreeBSD下安装ollama

Ollama是一个用于在本地运行大型语言模型(LLM)的开源框架。它支持多种操作系统,但是唯独不支持FreeBSD,于是尝试在FreeBSD里编译安装。

先上结论,官网的ollama没有编译成功,使用特供版可以安装成功。因为特…

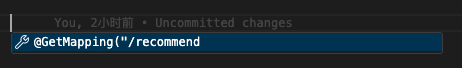

Ollama 运行 Cohere 的 command-r 模型

Ollama 运行 Cohere 的 command-r 模型 0. 引言1. 安装 MSYS22. 安装 Golang3. Build Ollama4. 运行 command-r 0. 引言

Command-R

Command-R 是一种大型语言模型,针对对话交互和长上下文任务进行了优化。它针对的是“可扩展”类别的模型,这些模型在高…

Spring Boot集成qwen:0.5b实现对话功能

1.什么是qwen:0.5b?

模型介绍:

Qwen1.5是阿里云推出的一系列大型语言模型。 Qwen是阿里云推出的一系列基于Transformer的大型语言模型,在大量数据(包括网页文本、书籍、代码等)进行了预训练。

硬件要求:…

Ollama部署在线ai聊天

概述:虽然ollama在Windows方面还有很多bug,但不妨碍它在ai领域上面的成就

第一步:安装Ollama

官网:Download Ollama on Windows 下载安装即可。说明一下ollama的安装位置只能是c盘,好像改不了,但是数据模…

开发个人Go-ChatGPT--4 用户管理

开发个人Go-ChatGPT–4 用户管理

先看下我的目录结构,可以根据个人爱好,进行重构

|-- Dockerfile

|-- LICENSE

|-- common

| |-- callmodel

| | |-- gemma.go

| | -- models.go

| |-- consts

| | |-- code.go

| | |-- common.go

|…

开发个人Go-ChatGPT--1 项目介绍

开发个人Go-ChatGPT--1 项目介绍 开发个人Go-ChatGPT--1 项目介绍知识点大纲文章目录项目地址 开发个人Go-ChatGPT–1 项目介绍

本文将以一个使用Ollama部署的ChatGPT为背景,主要还是介绍和学习使用 go-zero 框架,开发个人Go-ChatGPT的服务器后端&#…

开发个人Ollama-WebUI--1 项目介绍

开发个人Ollama-WebUI--1 项目介绍 开发个人Ollama-WebUI--1 项目介绍知识点大纲文章目录项目地址 开发个人Ollama-WebUI–1 项目介绍

本文将以一个使用Ollama部署的ChatGPT为背景,主要还是介绍和学习使用 go-zero 框架,开发个人Ollama-WebUI的服务器后…

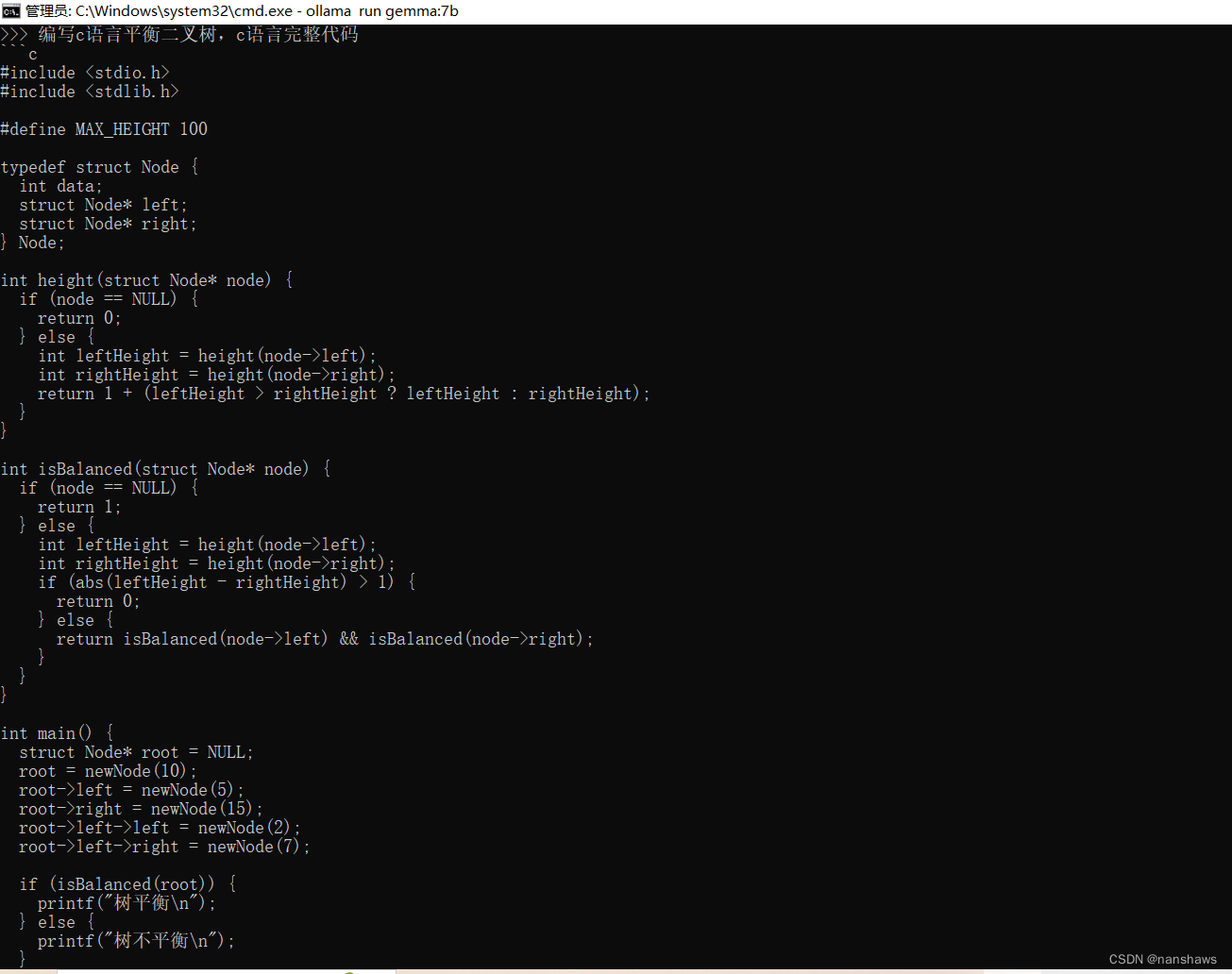

使用Ollama在本地运行AI大模型gemma

1.下载:

https://github.com/ollama/ollama/releases

2.配置环境变量

我的电脑-右键-属性-系统-高级系统设置-环境变量-【系统环境变量】新建

变量名:OLLAMA_MODELS (固定变量名) 变量值:E:\Ollama\Lib ࿰…

【ai技术】(4):在树莓派上,使用qwen0.5b大模型+chatgptweb,搭建本地大模型聊天环境,速度飞快,非常不错!

1,视频地址

https://www.bilibili.com/video/BV1VK421i7CZ/ 【ai技术】(4):在树莓派4上,使用ollama部署qwen0.5b大模型chatgptweb前端界面,搭建本地大模型聊天工具,速度飞快 2,下载…

Open WebUI大模型对话平台-适配Ollama

什么是Open WebUI

Open WebUI是一种可扩展、功能丰富、用户友好的大模型对话平台,旨在完全离线运行。它支持各种LLM运行程序,包括与Ollama和Openai兼容的API。

功能

直观的界面:我们的聊天界面灵感来自ChatGPT,确保了用户友好的体验。响应…

大模型之Ollama:在本地机器上释放大型语言模型的强大功能

LlaMA 3 系列博客

基于 LlaMA 3 LangGraph 在windows本地部署大模型 (一)

基于 LlaMA 3 LangGraph 在windows本地部署大模型 (二)

基于 LlaMA 3 LangGraph 在windows本地部署大模型 (三)

基于 LlaMA…

在Ubuntu上部署Open WebUI和Ollama,打造你的私人GPT

在Ubuntu上部署Open WebUI和Ollama,打造你的私人GPT

如果你对自然语言处理或者构建自己的对话AI感兴趣,那么这篇文章就是为你准备的。我将带你一步步搭建Open WebUI和Ollama,让你在自己的服务器上就能体验到强大的语言模型。

简介

Ollama是…

在Ubuntu上使用docker compose安装N卡GPU的Ollama服务

在现代计算环境中,利用 GPU 进行计算加速变得越来越重要。下面将讲解如何在Ubuntu上使用docker compose安装N卡GPU的Ollama服务。

1、安装 NVIDIA 容器工具

首先,需要确保你的系统已经安装了 NVIDIA 容器工具 nvidia-container-toolkit。这是让 Docker 容器访问 GPU 的关键…

Open-webui:本地化管理AI大模型

Open WebUI 是一个开源的用户界面工具,用于运行和管理大语言模型 (LLM) 及其他人工智能功能。它的主要目的是简化人工智能模型的本地部署和操作,让用户能够方便地通过浏览器界面与各种 AI 模型进行交互。

官方地址:https://github.com/open-…

LLM大语言模型私有化部署-OpenEuler22.03SP3上容器化部署Dify与Qwen2.5

背景

Dify 是一款开源的大语言模型(LLM) 应用开发平台。其直观的界面结合了 AI 工作流、 RAG 管道、 Agent 、模型管理、可观测性功能等,让您可以快速从原型到生产。相比 LangChain 这类有着锤子、钉子的工具箱开发库, Dify 提供了更接近生产需要的完整…

LLM大语言模型私有化部署-使用Dify与Qwen2.5打造专属知识库

背景

Dify 是一款开源的大语言模型(LLM) 应用开发平台。其直观的界面结合了 AI 工作流、 RAG 管道、 Agent 、模型管理、可观测性功能等,让您可以快速从原型到生产。相比 LangChain 这类有着锤子、钉子的工具箱开发库, Dify 提供了更接近生产需要的完整…

240909-ChuanhuChatGPT集成Ollama的环境配置

A. 最终效果 B. 需求文件

requirements.txt (至少需要安装这个,具体参见官网)requirements_advanced.txt (如果安装了Ollama,并且可以进行对话,可以不需要安装,具体参见官网)requirements_succcess.txt&am…

LLM大语言模型私有化部署-OpenEuler22.03SP3上容器化部署Ollama与OpenWebUI

背景

你是不是也有私有化部署大模型的需求?如今有了 Ollama , HuggingFace , ModelScope 等开源平台,我们可以非常方便地搭建一个属于自己的大模型,如果网速给力,真是分分钟~~。简单起见,这篇文…

llama-index,uncharted and llama2:7b run locally to generate Index

题意:本地运行 llama-index、uncharted 以及 llama2:7b 来生成索引 问题背景:

I wanted to use llama-index locally with ollama and llama3:8b to index utf-8 json file. I dont have a gpu. I use uncharted to convert docs into json. Now If it …

Ollama 运行从 ModelScope 下载的 GGUF 格式的模型

本文系统环境

Windows 10

Ollama 0.5.7

Ollama 是什么?

Ollama 可以让你快速集成和部署本地 AI 模型。它支持各种不同的 AI 模型,并允许用户通过简单的 API 进行调用

Ollama 的安装

Ollama 官网 有其下载及安装方法,非常简便

但如果希…

【LLM】Ollama框架入门指北

note

Ollama是一个开源框架,专门设计用于在本地运行大型语言模型。它的主要特点是将模型权重、配置和数据捆绑到一个包中,从而优化了设置和配置细节,包括GPU使用情况,简化了在本地运行大型模型的过程。Ollama提供了对模型量化的支…

DeepSeek r1本地安装全指南

环境基本要求

硬件配置

需要本地跑模型,兼顾质量、性能、速度以及满足日常开发需要,我们需要准备以下硬件:

CPU:I9内存:128GB硬盘:3-4TB 最新SSD,C盘确保有400GB,其它都可划成D盘…

本地部署DeepSeek教程(Mac版本)

第一步、下载 Ollama

官网地址:Ollama 点击 Download 下载 我这里是 macOS 环境 以 macOS 环境为主

下载完成后是一个压缩包,双击解压之后移到应用程序:

打开后会提示你到命令行中运行一下命令,附上截图: 若遇…

芯片AI深度实战:基础篇之Ollama

有这么多大模型,怎么本地用? Ollama可以解决这一问题。不依赖GPU,也不需要编程。就可以在CPU上运行自己的大模型。 软件甚至不用安装,直接在ollama官网下载可执行文件即可。

现在最流行的deepseek-r1也可以使用。当然还有我认为最…

走近科学IT版:Windows里Ollama关闭后还在占用11434端口

走近科学IT版:Ollama关闭后还在占用11434端口 退出Ollama之后,再次启动Ollama服务,报错:

(py311) E:\ai\ollama>ollama serve Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address (protocol/ne…

使用Ollama本地部署DeepSeek R1

前言

DeepSeek是一款开源的智能搜索引擎,能够通过深度学习技术提高搜索的智能化水平。如果你正在寻找一种方式来将DeepSeek部署在本地环境中,Ollama是一个非常方便的工具,它允许你在本地快速部署并管理各种基于AI的模型。

在本篇博客中&…

ollama如何将模型移动到D盘以及如何直接下载到D盘

看完本文,必然解决你的问题。

你在网页上或者B站视频上搜到的所有资料肯定都是修改环境变量:

修改环境变量要修改两个地方:

1、用户变量。

在path中增加:D:\Ollama

2、系统变量

在系统变量中增加也就是新建:

变…

在FreeBSD下安装Ollama并体验DeepSeek r1大模型

在FreeBSD下安装Ollama并体验DeepSeek r1大模型 在FreeBSD下安装Ollama

直接使用pkg安装即可:

sudo pkg install ollama

安装完成后,提示:

You installed ollama: the AI model runner.

To run ollama, plese open 2 terminals. 1. In t…

Deepseek本地部署(ollama+open-webui)

ollama

首先是安装ollama,这个非常简单

https://ollama.com/

下载安装即可

open-webui

这个是为了提供一个ui,毕竟我们也不想在cmd和模型交互,很不方便。

第一,需要安装python3.11,必须是3.11(其他版…

【大模型系列篇】构建企业级智能问答系统:Ollama + Dify + RAG 的完美组合

比较早之前我们整理过一篇关于通过部署Ollama和Open WebUI来搭建本地的问答系统,大家可以再跳转《本地问答系统-部署Ollama、Open WebUI》来阅读内容,今天我们通过上篇介绍的Dify 《加速AI应用开发:Dify——从构思到生产的一站式解决方案》&a…

【win10+RAGFlow+Ollama】搭建本地大模型助手(教程+源码)

一、RAGFlow简介

RAGFlow是一个基于对文档深入理解的开源RAG(Retrieval-augmented Generation,检索增强生成)引擎。 主要作用: 让用户创建自有知识库,根据设定的参数对知识库中的文件进行切块处理,用户向大…

LangChain Ollama实战文献检索助手(二)少样本提示FewShotPromptTemplate示例选择器

本期是用样例来提示大模型生成我们想要的答案。即在输入中给定提示的样例,以及提示模板,然后匹配较相关的样例进行文献综述。

创建示例样本FewShotPromptTemplate

这里我用GTP-o1生成了几个回答,作为样本

samples [{"theme": &…

【人工智能】:搭建本地AI服务——Ollama、LobeChat和Go语言的全方位实践指南

前言

随着自然语言处理(NLP)技术的快速发展,越来越多的企业和个人开发者寻求在本地环境中运行大型语言模型(LLM),以确保数据隐私和提高响应速度。Ollama 作为一个强大的本地运行框架,支持多种先…

Ubuntu -- 几行命令使用Ollama部署本地AI大模型, 仅调用api, 快速测试api效果

需求

需要在本地快速部署一个大模型, 然后使用 局域网 的其他电脑进行 api调用为了快速测试, 大模型选择了 qwen2:0.5B 进行快速测试 开始

下载安装 ollama

curl -fsSL https://ollama.com/install.sh | sh验证安装

ollama --version下载安装模型并运行

ollama run qwen2:…

解决llama_index中使用Ollama出现timed out 问题

现象: File "~/anaconda3/envs/leo_py38/lib/python3.8/site-packages/httpx/_transports/default.py", line 86, in map_httpcore_exceptionsraise mapped_exc(message) from exc

httpx.ReadTimeout: timed out代码:

from llama_index.core …

如何将自己本地项目开源到github上?

环境:

LLMB项目

问题描述:

如何将自己本地项目开源到github上?

解决方案:

步骤 1: 准备本地项目 确保项目整洁 确认所有的文件都在合适的位置,并且项目的 README.md 文件已经完善。检查是否有敏感信息࿰…

在win11系统笔记本中使用Ollama部署deepseek制作一个本地AI小助手!原来如此简单!!!

大家新年好啊,明天就是蛇年啦,蛇年快乐!

最近DeepSeek真的太火了,我也跟随B站,使用Ollama在一台Win11系统的笔记本电脑部署了DeepSeek。由于我的云服务器性能很差,虽然笔记本的性能也一般,但是…

python + ollama 手敲实现私有大模型知识库

在不依赖 LangChain、LlamaIndex 等框架,以及各种知识问答软件的情况下,尽量减少第三方库的使用,仅通过 Ollama 和 NumPy 两个外部库来实现 RAG(Retrieval-Augmented Generation)应用。

一、安装python

下载…

香橙派OPI4A,部署ollama+qwen2.5但是0.5B

在烧录好的系统上,配置好一切,开始部署ollama。

一、安装ollama

ollama官网,download,选择Linux,会告知你一个安装命令

curl -fsSL https://ollama.com/install.sh | sh

等待完成,查看版本 启动服务&am…

window系统下使用open-webui+ollama部署大模型

前面一篇博文中讲述了window下用ollama+AnythingLLM部署本地知识库,但是个人感觉anythingllm不是很好用,还不如直接用cmd窗口,而且仅能本机使用,如果想部署到服务器上面供其他人访问,完全不可行,但是使用open-webui+ollama或者独立的open-webui救可以实现。 使用open-web…

ollama语言大模型部署使用

ollama语言大模型部署使用 前言一、下载安装maxkb1、下载解压赋权2、安装 二、安装ollamadocker运行 三、无需获取api_keymaxkb安装ollama模型对,就是这,你选好基础模型后,只需要给他地址,添加完成后自行调用ollama安装你选择好的…

【10分钟本地部署大语言模型】借助1Panel、MaxKb、Ollama快速部署大语言模型(qwen、llama等)及知识库

前言:

本文介绍一种快速在Linux服务器(windows使用wsl也可以)上部署大语言模型(含知识库)的方式。 核心内容如下:

1Panel: 开源的Linux 服务器运维管理面板,通过该面板安装ollama和…

在Linux上如何让ollama在GPU上运行模型

之前一直在 Mac 上使用 ollama 所以没注意,最近在 Ubuntu 上运行发现一直在 CPU 上跑。我一开始以为是超显存了,因为 Mac 上如果超内存的话,那么就只用 CPU,但是我发现 Llama3.2 3B 只占用 3GB,这远没有超。看了一下命…

使用SpringAI快速实现离线/本地大模型应用

前言

大模型(LLM),Large Language Model作为当前比较热门的技术,最近在年在各行各业中都得到了广泛的应用。

在我们目前使用较多的AI产品中,几乎都是使用的互联网(云端)上的AI工具,即:需要先把数据传输给AI平台&…

使用Ollama 在Ubuntu运行deepseek大模型:以deepseek-r1为例

deepseek大模型上热搜啦! 咱们来亲身感受下DeepSeek模型的魅力吧!

整个操作流程非常简单方便,只需要2步,先安装Ollama,然后执行大模型即可。

支持的deepseek-r1模型

deepseek-r1

DeepSeek-R1-Distill-Qwen-1.5B

…

Open WebUI + Ollama 部署LLM大模型,实战教程

Open WebUI地址:https://github.com/open-webui/open-webui

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管网页用户界面(WebUI),设计旨在完全离线运行。它支持多种大型语言模型(LLM)运行器,包括 Ollama 和兼容 OpenAI 的 API。以下是 Open WebUI 的主要特点: …

设计一个流程来生成测试模型安全性的问题以及验证模型是否安全

要使用 Ollama 运行 llama3.3:70b 模型,并设计一个流程来生成测试模型安全性的问题以及验证模型是否安全,可以按照以下步骤进行设计和实现。整个过程包括环境配置、设计安全测试提示词、执行测试以及分析结果。以下是详细的步骤和指导:

1. 环…

![[译] RAGFlow 使用说明](https://i-blog.csdnimg.cn/direct/ce9ec15448e84eb7a04bdebe140f8a64.png)

![[2024-06]-[大模型]-[Ollama] 0-相关命令](https://img-blog.csdnimg.cn/direct/cbfab5ca57e44ec5a7dbb4f02604df70.png)